Spektralphotometrie

Moderator: Moderatoren

Spektralphotometrie

Guten Tag allerseits,

Ich habe mithilfe eines Spektralphotometers folgende Eichlösungen mit folgenden Absorptions oder Extinktionswerten gemessen.

Links ist die Konzentration. Rechts vermute ich Absorption.

100mg/l 1.11

250mg/l 1.47

500mg/l 1.77

750mg/l 1.96

1000mg/l 1.97

Aus diesen Werten soll ich eine Extinktionsgerade finden, doch diese Werte sind nicht auf einer Geraden.

Ausserdem weiss ich nicht welche Werte dies überhaupt sind.

Ich benötige die Extinktionsgerade um die Konzentration einer weiteren Küvette herauszufinden.

Danke für eure Hilfe.

Ich habe mithilfe eines Spektralphotometers folgende Eichlösungen mit folgenden Absorptions oder Extinktionswerten gemessen.

Links ist die Konzentration. Rechts vermute ich Absorption.

100mg/l 1.11

250mg/l 1.47

500mg/l 1.77

750mg/l 1.96

1000mg/l 1.97

Aus diesen Werten soll ich eine Extinktionsgerade finden, doch diese Werte sind nicht auf einer Geraden.

Ausserdem weiss ich nicht welche Werte dies überhaupt sind.

Ich benötige die Extinktionsgerade um die Konzentration einer weiteren Küvette herauszufinden.

Danke für eure Hilfe.

Dass deine Werte nicht in einer Gerade liegen hast du ja scheinbar schon mitbekommen, die Abweichungen lassen aber auf einen Systematischen Fehler schließen:

Mit den von dir bisher gegebenen Informationen kann man allerdings nichts anfangen, da du nicht einmal zu Wissen scheinst was für ein Gerät du benutzt hast. Bei Fragen wäre es sinnvoller sich an einen Assistenten aus dem Praktikum zu wenden.

NI2

Mit den von dir bisher gegebenen Informationen kann man allerdings nichts anfangen, da du nicht einmal zu Wissen scheinst was für ein Gerät du benutzt hast. Bei Fragen wäre es sinnvoller sich an einen Assistenten aus dem Praktikum zu wenden.

NI2

I❤OC

There is no sadder sight in the world than to see a beautiful theory killed by a brutal fact. [T. Huxley]

The pursuit of knowledge is hopeless and eternal. Hooray! [Prof. H. J. Farnsworth]

Trust the rhythm and the rhyme of your own heartbeat. [C. Douglas]

There is no sadder sight in the world than to see a beautiful theory killed by a brutal fact. [T. Huxley]

The pursuit of knowledge is hopeless and eternal. Hooray! [Prof. H. J. Farnsworth]

Trust the rhythm and the rhyme of your own heartbeat. [C. Douglas]

-

CD-ROM-LAUFWERK

- Illumina-Mitglied

- Beiträge: 581

- Registriert: Sonntag 5. Januar 2014, 23:05

Bitte nicht vergessen: Die Absorbanz (bzw. deutsch eher Extinktion) ist logarithmisch.

Bei A = 0 sind 0% des Lichtes absorbiert worden

Bei A = 1 sind 90% absorbiert worden

Bei A = 2 sind 99% absorbiert worden

Die Exktinktion sollte zwischen 0,1 und 1 liegen. Werte über 1 sind, aufgrund der fast vollständigen Absorption des Lichtes, mit Vorsicht zu genießen.

Grundsätzlich sollte man jede Lösung mehrfach messen, damit man die Schwankungen unter den Messungen beobachten kann. Dann würde man für die hohen Werte sehr große Schwankungen sehen, da das Gerät hier einfach nicht richtig arbeiten kann. Manche (bzw. moderne) Photometer messen automatisch mehrfach und geben gleich die (Standard-) Abweichung mit an.

Bei A = 0 sind 0% des Lichtes absorbiert worden

Bei A = 1 sind 90% absorbiert worden

Bei A = 2 sind 99% absorbiert worden

Die Exktinktion sollte zwischen 0,1 und 1 liegen. Werte über 1 sind, aufgrund der fast vollständigen Absorption des Lichtes, mit Vorsicht zu genießen.

Grundsätzlich sollte man jede Lösung mehrfach messen, damit man die Schwankungen unter den Messungen beobachten kann. Dann würde man für die hohen Werte sehr große Schwankungen sehen, da das Gerät hier einfach nicht richtig arbeiten kann. Manche (bzw. moderne) Photometer messen automatisch mehrfach und geben gleich die (Standard-) Abweichung mit an.

-

Reosir

- Illumina-Mitglied

- Beiträge: 156

- Registriert: Samstag 23. Juni 2018, 11:13

- Wohnort: Süddeutschland

Die 0,1 bis 1 würde ich aber eher als Optimalbereich bezeichnen. Wenn nötig kann man schon auch mit Extinktionen ganz knapp über 0 sinnvoll arbeiten. Bei UV-Detektoren für die HPLC, die ja auch nur schnelle Spektrometer sind, wird etwa mit Extinktionen bis unter 0,001 reproduzierbar quantifiziert ( z.B. https://www.agilent.com/cs/library/appl ... 2851EN.pdf ).CD-ROM-LAUFWERK hat geschrieben:Die Exktinktion sollte zwischen 0,1 und 1 liegen. Werte über 1 sind, aufgrund der fast vollständigen Absorption des Lichtes, mit Vorsicht zu genießen.

Bei der Obergrenze an sinnvoll nutzbaren Extinktionen würde ich auch eher zu höheren Werten tendieren: Hängt zwar noch von der Intensität der Lichtquelle in dem Bereich ab und von der Bandbreite. Aber üblicherweise dürfte 1% Restlicht selbst für ältere Geräte keine große Herausforderung sein: Abweichungen von der Linearität oder instabile Werte habe ich bei einem Standard-UV-Vis geschätzt aus den 1980ern eher über 2 , bei einem Gerät grob von 2005 über 3 bekommen.

@Chemied: Hast du denn keine Versuchsbeschreibung zu dem Experiment bekommen?

Zeit für etwas absurde Spekulation. Stellen wir uns mal vor, die Werte waren eigentlich alle bis auf einen Ausreißer auf einer Gerade und die geht auch wie es muss durch den Punkt (0,0):

Alles im optimalen Bereich zwischen 0.1 und 1.0, Bestimmtheitsmaß super, alles wie es soll.

Dann kommt ein Idiot und denkt, das seien lass mich lügen, Absorbtionswerte oder sowas, irgendwas, das in Prozent ausgegeben wird, deswegen multipliziert er es mit 100 und dann logarithmiert er, weil in seinem Kopf noch rumspukt, dass Extinktionen logarithmisch sind. Dann kriegt er exakt die Werte, wie angegeben.

Die liegen dann halt ziemlich genau auf einer log-Kurve und können gar keine Extinktionen sein, da sie nie und nimmer den Punkt (0,0) schneiden. Irgendjemand hat vermutlich mit den Werten ziemlichen Unsinn angestellt.

Das kann natürlich reiner Zufall sein, bei 5 Werten von denen man einen noch rausschmeißen muss, findet man nach einiger Zeit immer eine Erklärung. Die muss nur eben nichts mit der Realität zu tun haben...

Alles im optimalen Bereich zwischen 0.1 und 1.0, Bestimmtheitsmaß super, alles wie es soll.

Dann kommt ein Idiot und denkt, das seien lass mich lügen, Absorbtionswerte oder sowas, irgendwas, das in Prozent ausgegeben wird, deswegen multipliziert er es mit 100 und dann logarithmiert er, weil in seinem Kopf noch rumspukt, dass Extinktionen logarithmisch sind. Dann kriegt er exakt die Werte, wie angegeben.

Die liegen dann halt ziemlich genau auf einer log-Kurve und können gar keine Extinktionen sein, da sie nie und nimmer den Punkt (0,0) schneiden. Irgendjemand hat vermutlich mit den Werten ziemlichen Unsinn angestellt.

Das kann natürlich reiner Zufall sein, bei 5 Werten von denen man einen noch rausschmeißen muss, findet man nach einiger Zeit immer eine Erklärung. Die muss nur eben nichts mit der Realität zu tun haben...

-

Reosir

- Illumina-Mitglied

- Beiträge: 156

- Registriert: Samstag 23. Juni 2018, 11:13

- Wohnort: Süddeutschland

Gefällt mir deine SpekulationXyrofl hat geschrieben:Das kann natürlich reiner Zufall sein, bei 5 Werten von denen man einen noch rausschmeißen muss, findet man nach einiger Zeit immer eine Erklärung. Die muss nur eben nichts mit der Realität zu tun haben...

Dann müsste das aber ja schon in der Auswertemethode falsch drin sein, denn das Maximum ist aus dem Spektrum ja richtig abgelesen.

Es gäbe dann aber auch naheliegende Erklärungen für den "Ausreißer": Vergessen die Küvette von 750 auf 1000 zu wechseln oder beim Herstellen des Standards für 1000 in die Zeile von 750 gerutscht.

Geh zum Assistenten, der ist doch auskunftspflichtig. Wenn der dir das nicht erklären will, dann schildere dem Professor, dass du die Aufgaben nicht lösen kannst, weil man sich weigert, dir eine vernünftige Einweisung zu geben.Nur stellt sich mir nun die Frage was das SPM dann für Werte ausgespuckt hat

Ist doch eine Schande, dass du uns sowas fragen musst. Wir haben keine Ahnung, was bei euch in die Geräte eingetippt wurde... Deine Aufgabe ist nicht, irgendwelche absurden Fehler zu suchen, die dadurch zustande kommen, dass man mit dir nicht reden will, sondern mit Werten von denen du weißt, was sie sind eine anständige Auswertung zu machen.

Hättest du dabei Probleme, könnten wir dir helfen, aber so wird das schwer.

Mir ist das ganze ziemlich undurchsichtig.

Was wurde eigentlich untersucht? Welcher Analyt mit welcher Methode?

Was wurde eigentlich untersucht? Welcher Analyt mit welcher Methode?

"Alles sollte so einfach wie möglich gemacht werden. Aber nicht einfacher." (A. Einstein 1871 - 1955)

"Wer nur Chemie versteht, versteht auch die nicht recht!" (G.C. Lichtenberg, 1742 - 1799)

"Die gefährlichste Weltanschauung ist die Weltanschauung der Leute, die die Welt nie gesehen haben." (Alexander v. Humboldt, 1769 - 1859)

"Wer nur Chemie versteht, versteht auch die nicht recht!" (G.C. Lichtenberg, 1742 - 1799)

"Die gefährlichste Weltanschauung ist die Weltanschauung der Leute, die die Welt nie gesehen haben." (Alexander v. Humboldt, 1769 - 1859)

-

CD-ROM-LAUFWERK

- Illumina-Mitglied

- Beiträge: 581

- Registriert: Sonntag 5. Januar 2014, 23:05

Das ist natürlich schöne Zahlenspielerei Xyrofl, aber am Ende nur purer Zufall, dass die Punkte grob* einer Potenz bzw. logarithmus bzw. (beliebige Funktion²) folgen.

Alleine dass die zwei letzten Werte quasi gleich sind lässt die Schlussfolgerung zu, dass die zwei Werte "inhaltslos" sind. Das Photometer war hier einfach am Limit. Es bleiben dann nur noch 3 Punkte, die quantitative Informationen liefern. Durch diese 3 Punkte kann man so ziemlich alles legen. Da ist man schnell bei ziemlich unsinnigen Regressionen... Ich habe mich jetzt viele Monate mit solchen Sachen (Datenmodellierung, Regressionsrechnungen, Datenanalyse) beschäftigt... Wer mehr als die einfache lineare Regression anwendet, der sollte sich im klaren sein, dass die Aussagekraft womöglich nicht so hoch ist, wie man sich es vorstellt - oder man wendet es nur auf Sachen an, bei denen das nicht weiter schlimm ist. Das ist sicherlich auch mit ein Grund, weshalb man fast überall nur linare Regressionen sieht. Hier funktioniert das System halbwegs und ist simpel.

*Noch ein Wort zum R²: Das ist sehr mit Vorsicht zu genießen. Wenn es wenig Punkte gibt oder der Datenbereich über mehrere Potenzen bzw. einen großen Bereich geht, dann geht die Aussagekraft recht schnell richtung "ist halt ne Zahl". Auch bei der Anpassung des Fits (der Funktion) an die Messpunkte würden die hohen Werte alles zu ihrer Optimierung hin verzerren, da für diese schon kleine Fehler (bei Messwert 1000 ist 1% daneben schon 10) sehr viel stärker in die Quadratsummenminimierung einfließen als selbst große Fehler bei den Messwerten mit niedrigen Werten (bei 10 sind 10% nur 1 -> 10x kleiner und nach dem Quadrieren noch viel weniger). Zumindest eine leichte Verbesserung bezüglich R² ist das korrigierte R² - hier wird auch die Anzahl der Messpunkte mit in die Betrachtung einbezogen. Kurven weniger Punkte haben dann, so wie es sein soll, ggü. einer Kurve mit vielen Punkten eine geringeres korr. R² (= adj. R²) obwohl das einfache R² (im Beispiel) gleich wäre.

²Beispielsweise: ln(y) = a + b/ln(x) mit a=1.8965168 und b=-8.2666662 ist R² = 0,991. Ich schreibe absichtlich so viele Nachkommastellen, aber das ist natürlich völlig absurd. Das 95% Konfidenzintervall für b geht von -9,88 bis -6,65, die Aussagekraft dieser Spielerei geht gegen null. Die Aussagekraft wäre gut, wenn diese Werte denn auch so reproduzierbar wären. Dann würde auch das Konfidenzintervall auf einen sinnvollen Bereich schrumpfen und man könnte mit dieser nichtlinearen Regression arbeiten. Eine Extinktion muss nicht immer linear sein. Aber so, hier in diesem Fall, ist das absoluter Unsinn, auch von der theoretischen Grundlage her. Grundsätzlich sollte man nicht-linearen Regressionen wohl nur trauen, wenn auch die Konfidenzintervalle der Parameter mit angegeben sind und diese nicht gefühlt von -100% bis +100% gehen. Denn diese Konfidenzintervalle beinhalten viel wertvolle Informationen, wie man am Beispiel obene sehen kann. R² sieht zwar super aus, aber die zwei Parameter sind so unsicher, dass sie -20% bis +20% um den Wert liegen.

Alleine dass die zwei letzten Werte quasi gleich sind lässt die Schlussfolgerung zu, dass die zwei Werte "inhaltslos" sind. Das Photometer war hier einfach am Limit. Es bleiben dann nur noch 3 Punkte, die quantitative Informationen liefern. Durch diese 3 Punkte kann man so ziemlich alles legen. Da ist man schnell bei ziemlich unsinnigen Regressionen... Ich habe mich jetzt viele Monate mit solchen Sachen (Datenmodellierung, Regressionsrechnungen, Datenanalyse) beschäftigt... Wer mehr als die einfache lineare Regression anwendet, der sollte sich im klaren sein, dass die Aussagekraft womöglich nicht so hoch ist, wie man sich es vorstellt - oder man wendet es nur auf Sachen an, bei denen das nicht weiter schlimm ist. Das ist sicherlich auch mit ein Grund, weshalb man fast überall nur linare Regressionen sieht. Hier funktioniert das System halbwegs und ist simpel.

*Noch ein Wort zum R²: Das ist sehr mit Vorsicht zu genießen. Wenn es wenig Punkte gibt oder der Datenbereich über mehrere Potenzen bzw. einen großen Bereich geht, dann geht die Aussagekraft recht schnell richtung "ist halt ne Zahl". Auch bei der Anpassung des Fits (der Funktion) an die Messpunkte würden die hohen Werte alles zu ihrer Optimierung hin verzerren, da für diese schon kleine Fehler (bei Messwert 1000 ist 1% daneben schon 10) sehr viel stärker in die Quadratsummenminimierung einfließen als selbst große Fehler bei den Messwerten mit niedrigen Werten (bei 10 sind 10% nur 1 -> 10x kleiner und nach dem Quadrieren noch viel weniger). Zumindest eine leichte Verbesserung bezüglich R² ist das korrigierte R² - hier wird auch die Anzahl der Messpunkte mit in die Betrachtung einbezogen. Kurven weniger Punkte haben dann, so wie es sein soll, ggü. einer Kurve mit vielen Punkten eine geringeres korr. R² (= adj. R²) obwohl das einfache R² (im Beispiel) gleich wäre.

²Beispielsweise: ln(y) = a + b/ln(x) mit a=1.8965168 und b=-8.2666662 ist R² = 0,991. Ich schreibe absichtlich so viele Nachkommastellen, aber das ist natürlich völlig absurd. Das 95% Konfidenzintervall für b geht von -9,88 bis -6,65, die Aussagekraft dieser Spielerei geht gegen null. Die Aussagekraft wäre gut, wenn diese Werte denn auch so reproduzierbar wären. Dann würde auch das Konfidenzintervall auf einen sinnvollen Bereich schrumpfen und man könnte mit dieser nichtlinearen Regression arbeiten. Eine Extinktion muss nicht immer linear sein. Aber so, hier in diesem Fall, ist das absoluter Unsinn, auch von der theoretischen Grundlage her. Grundsätzlich sollte man nicht-linearen Regressionen wohl nur trauen, wenn auch die Konfidenzintervalle der Parameter mit angegeben sind und diese nicht gefühlt von -100% bis +100% gehen. Denn diese Konfidenzintervalle beinhalten viel wertvolle Informationen, wie man am Beispiel obene sehen kann. R² sieht zwar super aus, aber die zwei Parameter sind so unsicher, dass sie -20% bis +20% um den Wert liegen.

Da hat man aber noch eine weitere Dimension: Die Zeit. Und damit so viel mehr Datenpunkte (dutzende pro Sekunde?), die den Wert entsprechend sicherer machen. Das lässt sich daher nicht mit einem Photometer vergleichen. Zusätzlich hat man weniger Variablen im System, das hilft natürlich auch noch. Beim normalen Photometer ist eine Abweichung von 0,001 problemlos durch eine etwas geänderte Küvettenposition beim rein/raus überschritten. Wenn man 50x einfach nur eine Küvette mit reinem Wasser misst (dieselbe raus und wieder einsetzen) sieht man entsprechende Schwankungen. Reproduzierbarkeit wird leider oft viel zu wenig betrachtet... im Praktikum kann es an mangelnder Zeit liegen, aber dann ist es überladen und gehört reduziert, dass man sich wirklich mit Problemen aus der "echten Welt" rumschlagen kann und was lernt. Statt einfach nach Schema 0815 immer das selbe zu machen oder die Anleitung abzuarbeiten.Bei UV-Detektoren für die HPLC, die ja auch nur schnelle Spektrometer sind, wird etwa mit Extinktionen bis unter 0,001 reproduzierbar quantifiziert

-

Reosir

- Illumina-Mitglied

- Beiträge: 156

- Registriert: Samstag 23. Juni 2018, 11:13

- Wohnort: Süddeutschland

Eine längere Integrationszeit oder Mehrfachmessungen sind bei Spektrometern schon auch möglich. Da kann man leicht zu längeren Messzeiten kommen, als ein Peak an der HPLC einem Zeit gibt.CD-ROM-LAUFWERK hat geschrieben:Da hat man aber noch eine weitere Dimension: Die Zeit. Und damit so viel mehr Datenpunkte (dutzende pro Sekunde?), die den Wert entsprechend sicherer machen. Das lässt sich daher nicht mit einem Photometer vergleichen.Bei UV-Detektoren für die HPLC, die ja auch nur schnelle Spektrometer sind, wird etwa mit Extinktionen bis unter 0,001 reproduzierbar quantifiziert

Ja, solche kleinen Effekte sind für Messungen an den Grenzen des Machbaren schon entscheidend. Lässt sich aber auch umgehen, z.B. Referenzspektrum mit blankem Lösungsmittel aufnehmen und dann die Substanz direkt in die Küvette zugeben ohne sie zu bewegen. Außerdem hat man bei der Messung von Spektren statt einzelnen Wellenlängen den Vorteil, dass der Hauptteil der Störungen (z.B. Küvettenposition) halbwegs längenwellenunabhängig und damit bei der Auswertung korrigierbar ist.CD-ROM-LAUFWERK hat geschrieben:Zusätzlich hat man weniger Variablen im System, das hilft natürlich auch noch. Beim normalen Photometer ist eine Abweichung von 0,001 problemlos durch eine etwas geänderte Küvettenposition beim rein/raus überschritten. Wenn man 50x einfach nur eine Küvette mit reinem Wasser misst (dieselbe raus und wieder einsetzen) sieht man entsprechende Schwankungen.

Ich gebe aber zu, dass so was nicht Standard ist. Wollte nur nicht, dass der Eindruck entsteht, dass es da feste Grenzen für messbare Extinktionen geben würde. Wird halt nur immer aufwendiger und schwieriger.

Ja, nach meiner Erfahrung verschlimmert sich das seit Bachelor-Master aber eher noch.CD-ROM-LAUFWERK hat geschrieben:Reproduzierbarkeit wird leider oft viel zu wenig betrachtet... im Praktikum kann es an mangelnder Zeit liegen, aber dann ist es überladen und gehört reduziert, dass man sich wirklich mit Problemen aus der "echten Welt" rumschlagen kann und was lernt. Statt einfach nach Schema 0815 immer das selbe zu machen oder die Anleitung abzuarbeiten.

Das ist natürlich richtig und deswegen habe ich das auch gleich unter meinen Post geschrieben, dass es pure Spekulation ist, wobei die Logarithmusfunktion nicht mehr Parameter hat als die lineare Funktion, also nicht unbedingt so extrem flexibel ist wie andere nichtlineare Funktionen, sie ist ja nichts anderes als eine lineare Regression nach entsprechender Transformation des Koordinatensystems (früher mit Log-Papier gemacht). Die Transformationen sind auch noch nicht so wild wie bei der Lineweaver Burk oder Hanes Woolf Linearisierung, wo die Regressionsfunktion zwar linear ist, aber die Regressionsparameter völlig in ihrer Bedeutung verzerrt werden.aber am Ende nur purer Zufall, dass die Punkte grob* einer Potenz bzw. logarithmus bzw. (beliebige Funktion²) folgen.

Man kann dadurch fast alles legen, außer eine Kurve, die Sinn macht wenn das Extinktionen sein sollenDurch diese 3 Punkte kann man so ziemlich alles legen.

Beim R² sollte man auch nicht vergessen, dass es nur angibt, ob man mit dem gewählten Modell die gegebenen Daten abdecken kann, oder nicht. Das ist Korrelationsanalyse. Man fragt bei der Korrelationsanalyse einfach "Liegen die Datenpunkte so, dass sie durch das Modell abgedeckt werden können?" Bei einer Geraden ist das sehr einfach, dann lautet die Frage "Liegen die Punkte auf einer Geraden?" und das ist eine vernünftige Fragestellung. Die Frage, ob eine Punkwolke auf "einem Polynom zehnten Grades" liegt, ist eine sehr merkwürdige Frage, denn so ein Polynom kann eine unüberschaubare Vielzahl von Formen annehmen, die sich nicht ähneln. Wenn das Modell flexibel genug für perfekte Reproduktion ist (z.B. ein Polynom vom Grade N-1 für N Datenpunkte), dann ist R² natürlich automatisch 100% und das ist nicht irgendwie ein Fehler, sondern die Kernaussage des Bestimmtheitsmaßes. Es sagt dann ganz richtig aus, dass man die gegebenen Punkte mit dem Modell perfekt beschreiben, d.h. reproduzieren kann. Dass das totales Overfitting ist, sieht man natürlich sofort, aber danach fragt man nicht mit dem R² sondern mit Methoden der Kreuzvalidierung. Fragen nach Interpolationsfähigkeit und Extrapolationsfähigkeit des Modelles werden vom R² gar nicht beantwortet.

Die Fehlerintervalle der Regressionsparameter sind ja sowieso nicht Teil der Korrelationsanalyse sondern Teil der Regressionsanalyse, die nicht die Beschreibbarkeit durch das Modell (linear, polynomisch, oder wie auch immer) sondern die Qualität des jeweiligen Fits bewerten soll. Letzten Endes können aber selbst die ziemlich irrelevant werden. Wenn ich ein Modell habe, wo kleine Änderungen in den Parametern gigantische Änderungen im Modell bewirken, dann sind die Fehler der Parameter winzig, aber das Modell selbst hat gigantische Unsicherheiten. Andersherum kann ein Parameter, der praktisch keinen nennenswerten Einfluss auf das Modell hat beliebig streuen, ohne dass das Modell dadurch schlecht wird. Ich kann den Fit dann für fast alles verwenden (Interpolieren, Extrapolieren, Reproduzieren, usw.), außer um eben besagten Parameter abzulesen.

-

CD-ROM-LAUFWERK

- Illumina-Mitglied

- Beiträge: 581

- Registriert: Sonntag 5. Januar 2014, 23:05

Wenn einfach kein Blindwert gemessen wurde, dann sieht es schon wieder anders aus und da geht prima eine Gerade durch.Du kriegst da nämlich ums Verrecken keine Gerade durch (0,0)

Genau das glauben aber so ziemlich alle, die den Wert irgendwie kennen/benutzen. Sei es nun so wörtlich oder wie sie den Wert letztlich verwenden: Als Argument dafür, dass die Regression prima dafür geeignet ist, die abhängige(n) Variable(n) aus der (den) unabhängigen zu berechnen. Natürlich über den kompletten Bereich.Fragen nach Interpolationsfähigkeit [...] des Modelles werden vom R² gar nicht beantwortet.

Sensitivitätsanalyse. Die liefert mitunter wichtige neue Erkenntnisse. In meinem Fall konnte ich einen von 4 Parametern (Abhängige, Zielgröße) damit rauswerfen, da er einfach eine Konstante ist. Irgendwie hat man das in der Literatur mehrfach nicht geschafft und hat dann absurde Modellierungen für diesen Parameter gehabt...kleine Änderungen in den Parametern gigantische Änderungen im Modell

Dann ist der Parameter nutzlos und fliegt raus bzw. neues Modell, ebenfalls eine wichtige Erkenntniss. Sei es nun wegen overfitting oder sonstwas.ein Parameter, der praktisch keinen nennenswerten Einfluss auf das Modell hat

Wir entfernen uns allerdings recht stark vom Thema des Threads...

Sehr interessant die Diskussionen hier

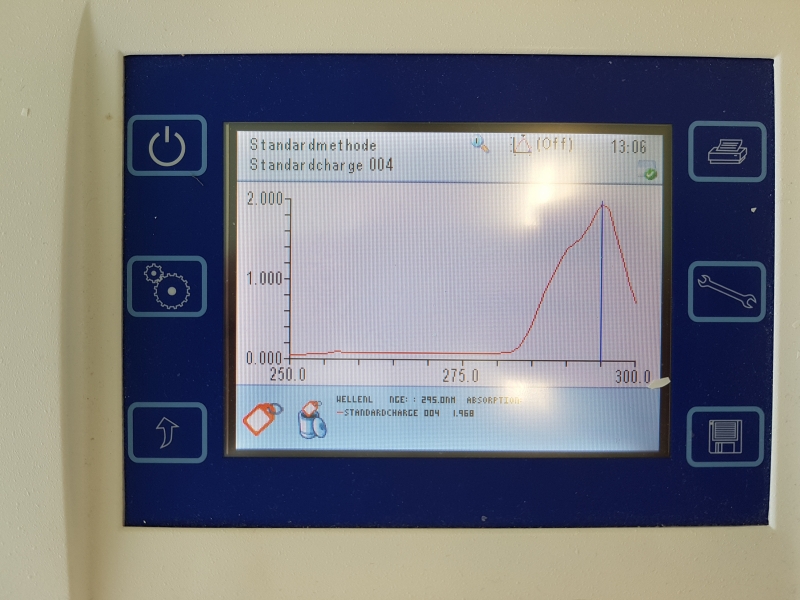

Endlich habe ich den Namen des verwendeten Geräts herausgefunden;

Jenway 6705 UV/Vis Spectrophotometer

Es gibt 2 Modi die in Frage kämen, die ich möglicherweise benutzt habe

Scanning Mode

The Jenway 6705 photometers can record scanning spectra, however better results can be obtained from a dual-beam instrument. Scanning spectra are often recorded in order to determine the wavelength of maximum absorbance (λmax) which can then be used for photometric or kinetic measurements, or to provide characterisation data for a compound.

Photometric Mode

Photometric mode is used to record absorbance values at a given wavelength. As absorbance is related to concentration through the Beer-Lambert law (A = ε c l), the concentration of a solution can be determined through the use of standards and recording a set of measurements in photometric mode.

Ebenso kann ich sagen, dass die Messwerte von 250mg/l; 500mg/l; 750mg/l die gleichmässigsten Absorptionskurven haben

Endlich habe ich den Namen des verwendeten Geräts herausgefunden;

Jenway 6705 UV/Vis Spectrophotometer

Es gibt 2 Modi die in Frage kämen, die ich möglicherweise benutzt habe

Scanning Mode

The Jenway 6705 photometers can record scanning spectra, however better results can be obtained from a dual-beam instrument. Scanning spectra are often recorded in order to determine the wavelength of maximum absorbance (λmax) which can then be used for photometric or kinetic measurements, or to provide characterisation data for a compound.

Photometric Mode

Photometric mode is used to record absorbance values at a given wavelength. As absorbance is related to concentration through the Beer-Lambert law (A = ε c l), the concentration of a solution can be determined through the use of standards and recording a set of measurements in photometric mode.

Ebenso kann ich sagen, dass die Messwerte von 250mg/l; 500mg/l; 750mg/l die gleichmässigsten Absorptionskurven haben